Η τεχνητή νοημοσύνη «σκοντάφτει» στα λάθος δεδομένα

Οι επιχειρήσεις θέλουν να υλοποιήσουν λύσεις τεχνητής νοημοσύνης, ωστόσο, δεν διαθέτουν τα αξιόπιστα δεδομένα που θα τις στηρίξουν. Αυτό είναι το βασικό συμπέρασμα της νέας παγκόσμιας έρευνας State of Data & Analytics της Salesforce, η οποία καταγράφει έναν ολοένα και πιο έντονο ανταγωνισμό για αξιοποίηση της AI, την ώρα που οι θεμελιώδεις υποδομές δεδομένων παραμένουν ανεπαρκείς.

Χάσμα μεταξύ φιλοδοξιών AI και πραγματικής ετοιμότητας: παρωχημένα data, κατακερματισμένες υποδομές, χαμηλή εμπιστοσύνη

Σύμφωνα με την έρευνα, ενώ το 76% των επιχειρηματικών ηγετών δηλώνει ότι βρίσκεται υπό αυξανόμενη πίεση να αποδείξει την αξία των δεδομένων, η πραγματικότητα δείχνει σημαντικά εμπόδια, από ελλιπείς βάσεις μέχρι αποσπασματικές εφαρμογές, που «παγιδεύουν» κρίσιμες πληροφορίες.

Παρά το γεγονός ότι το 63% των επιχειρηματικών ηγετών χαρακτηρίζει πλέον τις εταιρείες τους «data-driven», οι υπεύθυνοι δεδομένων έχουν διαφορετική εικόνα: το ίδιο ποσοστό (63%) αναφέρει ότι οι οργανισμοί δυσκολεύονται να προωθήσουν επιχειρηματικές προτεραιότητες μέσω της αξιοποίησης των δεδομένων. Πρόκειται για ένα σαφές χάσμα μεταξύ αντίληψης και πραγματικότητας, όπως επισημαίνει η έρευνα.

Τα ευρήματά της, επιβεβαιώνουν ότι η ποιότητα των δεδομένων παραμένει ο μεγαλύτερος ανασταλτικός παράγοντας. Μόνο το 49% των ηγετών θεωρεί ότι μπορεί να παράγει αξιόπιστες και έγκαιρες πληροφορίες, ενώ το 49% των data leaders δηλώνει ότι οι οργανισμοί καταλήγουν σε λανθασμένα συμπεράσματα εξαιτίας ανεπαρκούς επιχειρηματικού πλαισίου.

Εκπαίδευση μοντέλων

Τα προβλήματα αυτά εντείνονται, όταν τα δεδομένα χρησιμοποιούνται για την εκπαίδευση μοντέλων τεχνητής νοημοσύνης: το 89% των υπευθύνων δεδομένων έχει δει ανακριβή ή παραπλανητικά αποτελέσματα, ενώ το 55% παραδέχεται ότι σπατάλησε πόρους εκπαιδεύοντας μοντέλα πάνω σε εσφαλμένα δεδομένα.

Ως αποτέλεσμα, η ανησυχία είναι διάχυτη: το 42% των στελεχών, που υλοποιούν AI, δεν εμπιστεύεται πλήρως τα αποτελέσματα, καθώς προέρχονται από αποσπασματικές, παρωχημένες ή μη συνδεδεμένες βάσεις.

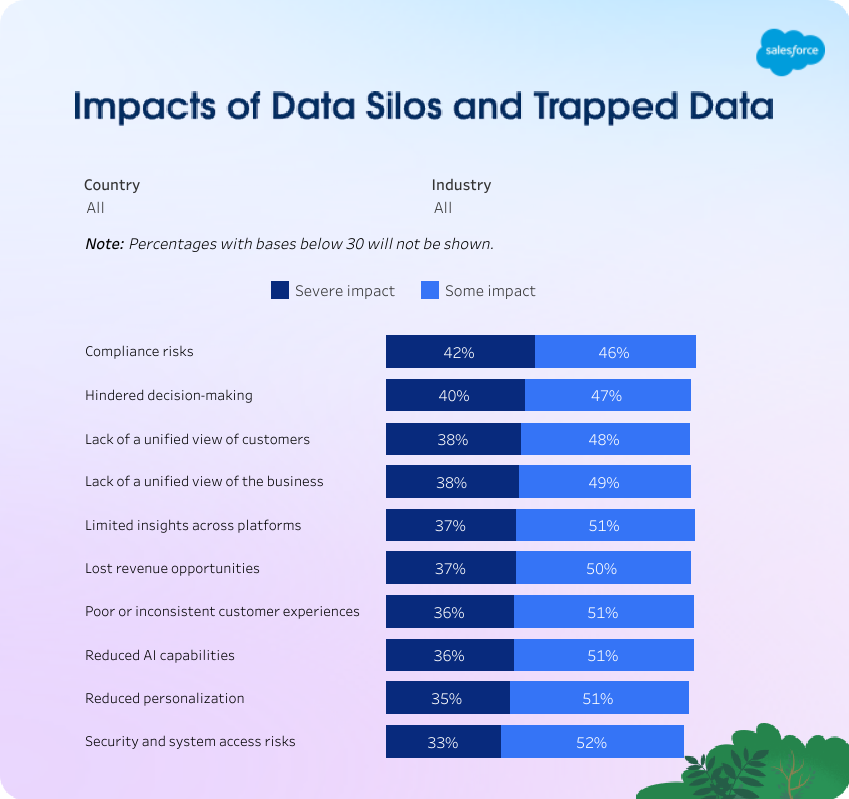

Η έρευνα δείχνει ότι ακόμη και τα ποιοτικά δεδομένα χάνουν την αξία τους, όταν βρίσκονται «παγιδευμένα» σε συστήματα που δεν επικοινωνούν μεταξύ τους. Ο μέσος οργανισμός χρησιμοποιεί 897 εφαρμογές, αλλά μόλις το 29% είναι διασυνδεδεμένες. Το αποτέλεσμα είναι δημιουργία σιλό που δυσκολεύουν ή και εμποδίζουν την πρόσβαση.

Σε αυτό το πλαίσιο, εκτιμάται ότι το 19% των εταιρικών δεδομένων είναι απομονωμένο ή μη αξιοποιήσιμο, με το 70% των data leaders να πιστεύει πως οι πιο πολύτιμες πληροφορίες βρίσκονται μέσα σε αυτό το «απρόσιτο» ποσοστό.

Η κατάσταση αυτή δεν επιβραδύνει απλώς τις επιχειρηματικές αποφάσεις, υπονομεύει την ικανότητα των οργανισμών να αξιοποιήσουν την τεχνητή νοημοσύνη σε κλίμακα, την ώρα που η πίεση αυξάνεται. Το 67% των στελεχών δεδομένων και ανάλυσης δηλώνει ότι καλείται να υλοποιήσει AI ταχύτερα από όσο επιτρέπει η πραγματική ετοιμότητα των συστημάτων τους.

Η στροφή στο “zero copy”

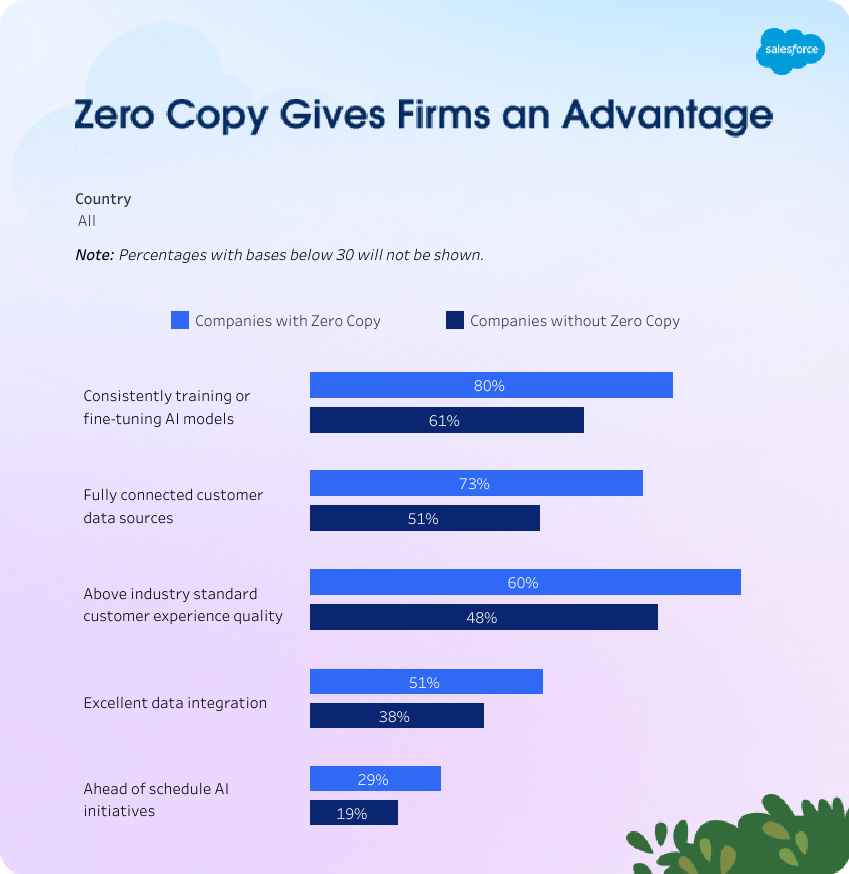

Για να αντιμετωπίσουν τον κατακερματισμό και να επιταχύνουν την υλοποίηση AI, όλο και περισσότεροι οργανισμοί εξετάζουν νέες αρχιτεκτονικές πρόσβασης στα δεδομένα. Σύμφωνα με την έρευνα, το 56% των οργανισμών υιοθετεί αρχιτεκτονική “zero copy”, μια προσέγγιση που επιτρέπει πρόσβαση σε δεδομένα από πολλαπλές βάσεις χωρίς μετακίνηση ή αντιγραφή.

Τα αποτελέσματα είναι ήδη ορατά, σύμφωνα με την έρευνα. Οι εταιρείες, που εφαρμόζουν zero copy, έχουν 25% μεγαλύτερη πιθανότητα να προσφέρουν ανώτερη εμπειρία πελάτη και 34% μεγαλύτερη πιθανότητα επιτυχίας στις πρωτοβουλίες τεχνητής νοημοσύνης.